O Custo do Progresso da Inteligência Artificial: o GPT tem um ‘preço salgado’!

E como fica a sustentabilidade nessa história?

Imagine que a criação de uma inteligência artificial (IA) é como treinar um atleta de nível olímpico. Assim como um atleta precisa de horas de treino e equipamentos especializados, as IAs precisam de tempo de computação e recursos para "aprender". Hoje, falaremos de um aspecto no mínimo curioso: o custo real por trás do desenvolvimento dessas tecnologias avançadas.

O Alto Preço do Treinamento de IA

Recentemente, o relatório AI Index de 2024 nos deu uma ideia clara do que realmente custa para "treinar" esses atletas digitais. Mas o que isso realmente significa? Primeiro, imagine que cada IA é um "cérebro" que precisa estudar. O "estudo" é o treinamento e, assim como os custos de educação podem variar, o mesmo ocorre com o treinamento de IA.

A Balança do Desempenho e do Investimento

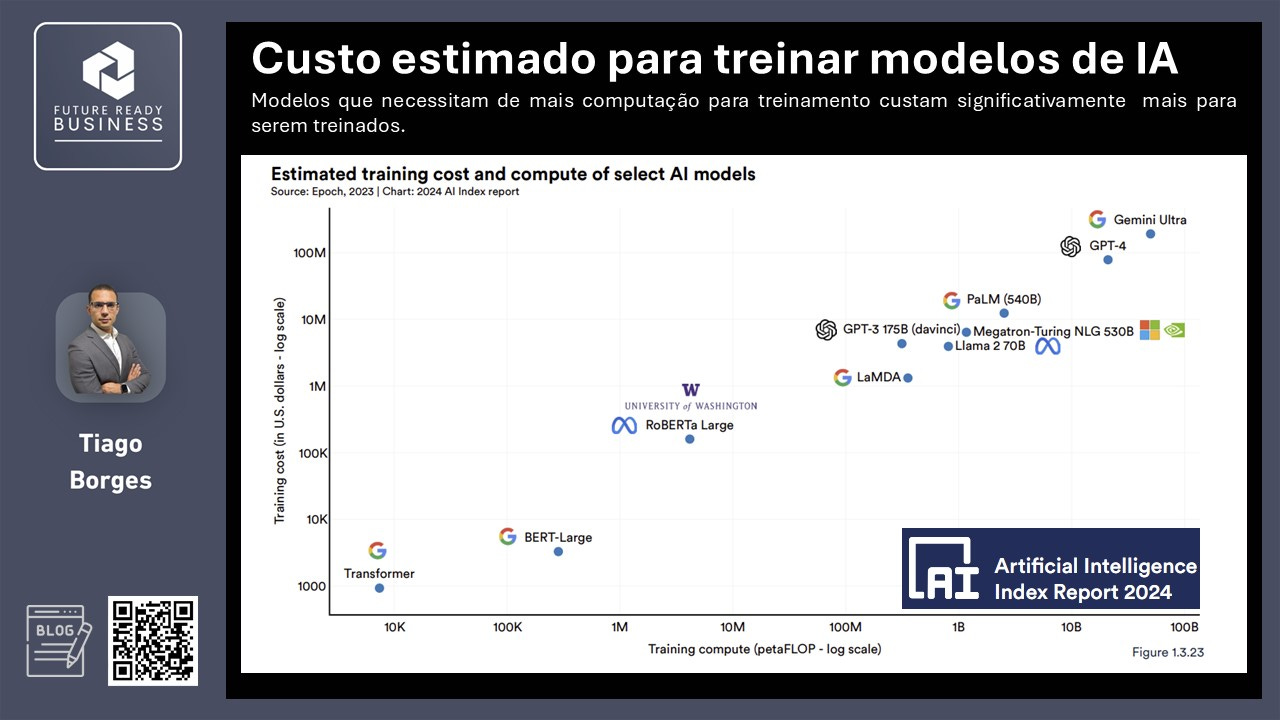

Relatórios passados do AI Index já documentaram uma conexão clara: quanto maiores as demandas computacionais para o treinamento de modelos de IA, maiores são os custos associados. Isso é evidenciado claramente no gráfico abaixo, onde se percebe que os modelos que requerem maior poder de computação para serem treinados tendem a ter custos de treinamento significativamente mais elevados.

Um modelo de IA, como o GPT-3 da OpenAI, pode precisar de cerca de 10 petaFLOPs de capacidade de computação. "PetaFLOPs" pode soar como um termo complicado, mas vamos simplificar: pense nele como a quantidade de cálculos matemáticos que um computador é capaz de realizar em um segundo. Um petaFLOP equivale a uma quantidade astronômica — estamos falando de um quadrilhão de cálculos! Para treinar o GPT-3, esse esforço custou aproximadamente 4,3 milhões de dólares.

Os Gigantes da Tecnologia

O Gemini Ultra e o GPT-4 são os tais gigantes. Estes modelos são como as estrelas do Oscar da IA, com capacidades de computação e custos que vão muito além do que a maioria das outras IAs. O Gemini Ultra da Google, por exemplo, chegou a um. investimento de 191,4 milhões de dólares em 2023. Já o GPT-4 teve um custo de 78,3 milhões de dólares em 2023.

Tudo bem! Mas porque isso é relevante?

O desenvolvimento de IA já está moldando o presente e caminha a passos largos para provocar mudanças ainda maiores. A cada avanço, surgem novas ferramentas e possibilidades que podem tornar diversas atividades mais fáceis e seguras, permitindo-nos dedicar tempo àquelas que geram mais valor. No entanto, esses avanços têm um custo real — financeiro, de recursos e, cada vez mais, ambiental.

Sustentabilidade e Acessibilidade

O fascínio pelo que a IA pode fazer deve ser acompanhado pelo questionamento sobre os seus potenciais impactos, tanto negativos quanto positivos. Estamos preparados para arcar com os custos e as consequências de criar modelos e máquinas que demandarão o equivalente energético de pequenas cidades?

O desenvolvimento e treinamento de modelos de inteligência artificial (IA) de grande escala, os conhecidos LLM, têm impactos ambientais significativos, principalmente devido ao alto consumo de energia. Por exemplo, o treinamento de modelos avançados como o GPT-3 pode consumir uma quantidade de energia equivalente a quase três meses de consumo de energia de uma casa média nos EUA (AIgantic). Esta energia frequentemente vem de fontes de combustíveis fósseis, contribuindo para emissões consideráveis de gases de efeito estufa (aumento da pegada de carbono).

Estima-se que treinar um único modelo de IA resulte em uma emissão de carbono comparável à emitida por cinco carros ao longo de suas vidas (MIT Technology Review). Isso destaca a urgente necessidade de desenvolver práticas mais sustentáveis na pesquisa de IA.

Diversas abordagens estão sendo exploradas para minimizar o impacto ambiental do treinamento de IA, incluindo o desenvolvimento de algoritmos mais eficientes, a otimização de especificações de hardware e o uso de fontes de energia renováveis para alimentar os data centers. Além disso, há um movimento crescente para promover a colaboração e compartilhamento de modelos treinados para reduzir os esforços de treinamento duplicados e o consumo geral de energia (AIgantic).

Diante desses desafios, a comunidade de IA está cada vez mais consciente das implicações ambientais do treinamento de grandes modelos e busca ativamente soluções energeticamente eficientes e sustentáveis (AIgantic). Essa conscientização é fundamental para garantir que o avanço da tecnologia não ocorra à revelia da preservação do meio ambiente.

Por outro lado, verifica-se que os recursos necessários para produzir resultados relevantes que possam ser publicados estão tornando cada vez mais desafiador para as pessoas no meio acadêmico continuarem a contribuir para as pesquisas em IA. Há uma barreira de acessibilidade para o desenvolvimento de pesquisas em virtude dos altos investimentos, notadamente realizados pela OpenAI e pelo Google, por exemplo.

Esse aumento nas despesas de treinamento efetivamente excluiu as universidades, tradicionalmente centros de pesquisa em IA, de desenvolverem seus próprios modelos de ponta. Em resposta, iniciativas políticas, como a Ordem Executiva sobre IA do presidente Biden, procuraram nivelar o campo de jogo entre a indústria e a academia, criando um Recurso Nacional de Pesquisa em IA, que concederia aos atores não industriais o computador e os dados necessários para realizar pesquisas de IA de alto nível. Essa ação é fundamental para manter o envolvimento acadêmico na fronteira da pesquisa em IA, permitindo que as universidades também possam inovar e contribuir com novos desenvolvimentos tecnológicos.

Considerações Finais

Como entusiastas, criadores ou simplesmente curiosos, é essencial que tenhamos um diálogo aberto sobre o custo da inovação e quem realmente paga a conta. Enquanto você lê este artigo, novos modelos de IA estão sendo desenvolvidos, cada um prometendo superar o último em habilidade e inteligência. Mas com cada avanço, precisamos perguntar: Estamos progredindo de forma responsável?

O que você acha? Participe da conversa nos comentários abaixo!

Fontes:

AI Index 2024 Report: Utilizado para discutir custos e impactos ambientais do treinamento de modelos de IA. Disponível em: AI Index 2024 Report.

MIT Technology Review: Referência para discutir a emissão de carbono equivalente ao emitido por cinco carros ao longo de suas vidas devido ao treinamento de um único modelo de IA. Informações mais detalhadas podem ser encontradas no site da MIT Technology Review.

Nature: Citado para discutir os custos ambientais crescentes da IA generativa e como eles são frequentemente mantidos em segredo. Mais informações podem ser encontradas em Nature.

AIgantic: Referência para detalhes sobre o impacto ambiental e as estratégias para reduzir o consumo de energia no treinamento de grandes modelos de IA. Mais detalhes podem ser consultados em AIgantic.